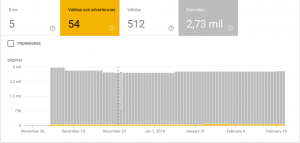

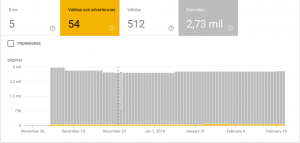

En Search Console podemos encontrar 4 tipos de mensajes sobre problemas en la cobertura del índice: error, válidas con advertencias, válidas y excluidas. Search Console nos enviará notificaciones cuando se encuentren distintos problemas en la cobertura, de las cuales lo ideal sería entender todos los problemas, averiguar si realmente son importantes y solucionar aquellos que no deberían aparecer.

Notificaciones de error en la cobertura del índice

Son páginas que por algún motivo no pueden indexarse en el índice de Google. Esto que a primera vista puede parecer bastante grave por el rojo de la notificación hay que saber entenderlo para comprender su importancia. Lo más normal es que este error aparezca porque el robot se topa con urls que tiene la metaetiqueta robots con el valor noindex y pueden darse varias soluciones:

- Quitar ese noindex si está puesto por error.

- Si no está puesto por error lo ideal sería que esa página esté oculta al rastreo del robot bien no enlazándola desde ninguna parte, ofuscando el enlace o el más elemental de los casos cortarla en robots.txt. Mi consejo es que siempre que se pueda se elimine ese contenido.

Válidas pero con advertencias

Pueden ser varias las advertencias, normalmente la que me vengo encontrando es esta: «Se ha indexado aunque un archivo robots.txt la ha bloqueado» y esto suele pasar porque se ha cortado urls en robots.txt sin su previa des-indexación. Lo correcto sería des-indexarlas y para ello se pueden usar algunos de los métodos que propongo aquí.

Válidas

Pongo este punto simplemente para deciros que el que sean válidas no quiere decir que estén bien. Habría que revisar las válidas para ver si realmente lo que está indexado es lo que nosotros queremos que se indexe. Además en este punto podremos ver que url de las indexadas están dentro del sitemap y cuáles no.

Excluidas

Aquí es dónde más variedad de errores podemos encontrar, entre ellos:

- Página duplicada sin etiqueta canónica. Es una página que el robot considera duplicada a la que no se le ha especificado su url canonical y el ha decidido excluirla del índice. Lo ideal sería eliminar todo referencia a esta página o al menos configurar de forma correcta la canonical.

- Página alternativa con etiqueta canónica adecuada. Similar a lo anterior pero si tiene la etiqueta canonical configurada. Puede pasar por urls dinámica recomiendo minimizar los casos.

- Excluida por una etiqueta «noindex». Similar al primer punto que he detallado y recomiendo la misma solución, si bien cabe destacar que este informe pueden aparece páginas como los sitemaps o partes privadas que es correcto que estén así.

- Descubierta: actualmente sin indexar. Nueva página que todavía no ha sido indexada. Desde la propia SC la podemos enviar al índice si es adecuada o tomaremos las medidas oportunas para que no se indexe si no es apropiada.

- La URL enviada no se ha seleccionado como canónica. Se ha enviado una url, probablemente en el sitemap, pero no existe otra versión que el robot a considerado como la original o la canónical.

- Bloqueada por robots.txt. Simplemente la hemos cortado en robots.txt y por eso no se ha accedido.

- No se ha encontrado (404). Esa página se sirve como 404. Puede pasar con contenido que se ha borrado y si este no tiene ningún enlace externo o interno tarde o temprano desaparecerá.

- Anomalía en el rastreo. Se ha producido una anomalía sin determinar al recuperar la URL, lo que podría implicar un código de respuesta 4xx o 5xx. Prueba a recuperar la página con Explorar como Google para ver si detecta algún problema de recuperación.

- Soft (404). Error 404 leve, en muchas ocasiones he visto este error cuando se hace una redirección 301 hacía una página que no es similar a la actual.

Lo que os dejo en los puntos anteriores es mi explicación para los errores que he ido viendo en diversos clientes, pero para más información pueden verse todos los problemas con la explicación oficial de Google dentro de los recursos para Web Masters.

Hola, no entiendo porque recomiendas que los contenidos con no index seaan eliminados o no enlazados. En mi caso tengo marcados varios artículos con no index porque me interesa que los lean (aportan información complementaria) pero no quiero que google lo indexe para que no se posicionen mejor que la página que complementan. Tampoco quiero bloquearlos a los robots porque no quiero que se indexen, pero si que se sigan sus enlaces.

Un saludo

Buenos días. Según comentas tu caso es algo puntual y que has decidido que sea así. Yo me refiero a casos en los que se tengan muchos contenidos a noindex o que esté pasando de forma no intencionada.

Hola

Las categorias de mi tienda ha desaparecido de google porque me aparece éste mensaje:

La URL enviada contiene la etiqueta «noindex»

¿Como puedo quitarla y que las vuelva a indexar??

Muchas gracias.

Eso depende del CMSs que uses. Me parece que va a ser un WooCommerce con SEO Yoas ¿verdad?

Hola, acabo de dar con tu post, bien detallado, tengo varios blogs, algunos no escribo mucho pero siempre han tenido buen tráfico (tampoco como un influencer, pero tenía tráfico diario) y observo que hace tiempo que no lo mira ni el toto, yo al entrar al nuevo Google Console, me saltan un montón de URL que dice así:

La URL no está en Google

This page is not in the index, but not because of an error. See the details below to learn why it wasn’t indexed. Más información

¿Ha cambiado la página?

Cobertura

Duplicada: la URL enviada no se ha seleccionado como canónica

Ahora, tu me dices que elimine contenido, pero cómo voy a eliminar contenido? son artículos que me costaron días en armarlo, no es una publicidad ni una descripción de producto de tres renglones, son investigación de historia, (en este caso que hablo hay otros blogs de recetas, es que ya Google ni lo esta indexando cuando antes funcionaba bien)

No tengo puñetera idea dónde tocar, estoy hasta los mismísimos que años de trabajo porque el algoritmo de los cojones se le da por tirar a la basura un montón de esfuerzo y trabajo.

Yo no he duplicado nada, no sé si tiene que ver que al pasar Blogger los http: a https: pueda generar el propio CMS ese conflicto..

Yo ya no sé que hacer.. blogs con movimientos, el mío principal de mi trabajo (Community Manager) también lo ha tirado abajo, he notado un bajón impresionante, ya no puedo monetizar como antes, 5 años escribiendo contenido útil para nada..

Otros casos, me hablan de etiqueta de «HRF» «a» no válida y me muestra todo el html y qué hago??? no soy desarrolladora web!

Perdón por la tabarra, pero ya me cansé de Google y sus zoológico de algoritmos que terminan jodiendo el trabajo de años de muchos profesionales.

Perdona pero no termino de comprender.

Estoy empezando un blog y search console al analizar cobertura me dice:

Válidas con advertencia …. 34

1 problema

Mas abajo dice:

Advertencia: Se ha indexado aunque un archivo robots.txt la ha bloqueado

Las páginas en cuestión son todas del tipo:

https…. midominio/search/label/etiquetas y una que pone https…midominio/search

¿Que debo hacer? (midominio es canalenigmas . org)

Hola Juan Luis mucho gusto! Encontré tu post en medio de un estado de desesperación ya que hace días envié por primera vez el sitemap de mi sitio (aclaro que fueron varias URL’s con contenido) y en el informe del Search Console me dice que «se ha detectado la etiqueta noindex en el encabezado HTTP X-Robots-Tag», verifiqué la configuración del Yoast SEO y todas las páginas/entradas publicadas se encuentran en index-follow al igual que el sitio en general, hice la verificación y el sitio no se encuentra bloqueado por robots txt., entonces como quito el “no index” para que google pueda indexar mi sitio? (Con esto me refiero a cuál sería la ruta en wordpress para encontrar este problema.)

Gracias de antemano!

Buenas , gracias por la info espero me puedas dar tu punto de vista , después de hacer un 301 de un dominio viejo a uno nuevo tengo mas de 4 k de no index son todas url con feed al final que no sirven recomendas eliminarlas ? ya que no tienen ningun tipo de utilidad , gracias y un saludo

Buenos días, en principio es una notificación de SC. Si ya no tienes enlaces hacía /feed no es algo prioritario de solucionar. Si lo quieres hacer mi consejo es que de alguna forma (.htaccess??) consigas que todas las urls /feed/ retornen un 410. Crea un sitemap de esas urls y súbelo a SC.

Saludos y gracias por comentar.

¿Has revisado el código fuente que se genera?

Buenas a todos,

Argenta, a mi me ocurre exactamente lo mismo que a ti.

¿Encontraste la solución?

Hola, Comó puedo eliminar el NoIndex de mis paginas?, uso wordpress a traves de Bluehost.

¿Has mirado en las opciones de lectura si tienes marcado lo de «disuadir a los buscadores»?

Hola, tengo algunas páginas con «no-index» en mi web. Esto es así a propósito, pero Google search console me informa de ello como si fuese un problema. ¿Que debo hacer para que Google Search Console» entienda que esas páginas no se deben indexar, y que no hay nada que corregir?

Gracias y enhorabuena por el blog

Si el no-index lo has puesto de forma voluntaria y está en una página que no quieres indexar no es un error. Otra cosa es que pudiera ser mejor no publicar contenido que no se quiera indexar o en caso de hacerlo enlazarlo de forma ofuscada pero no sé el caso concreto para decirte.